什么样的数据被AI大模型需要?

2025-01-22 17:45 浏览量:193

AI浪潮之下,互联网大厂“内卷”的赛道尤为默契,一致将目标锁定大模型。从百度的文心一言到阿里的通义千问,从腾讯混元到字节豆包……各厂均卷出了自家的大模型。而在大家疯狂训练大模型的背后,数据这一“硬通货”尤为重要。

毕竟,数据是大模型的“粮食”。数据的质量和数量将直接影响着大模型的性能和准确度。随着大模型赛道的加速“内卷”,未来对于数据的需求量只会越来越多,质量要求也会越来越高。

数据将是未来AI大模型竞争的关键要素

人工智能发展的突破得益于高质量数据的发展。例如,大型语言模型的最新进展依赖于更高质量、更丰富的训练数据集:与GPT-2相比,GPT-3对模型架构只进行了微小的修改,但花费精力收集更大的高质量数据集进行训练。ChatGPT与GPT-3的模型架构类似,并使用RLHF(来自人工反馈过程的强化学习)来生成用于微调的高质量标记数据。

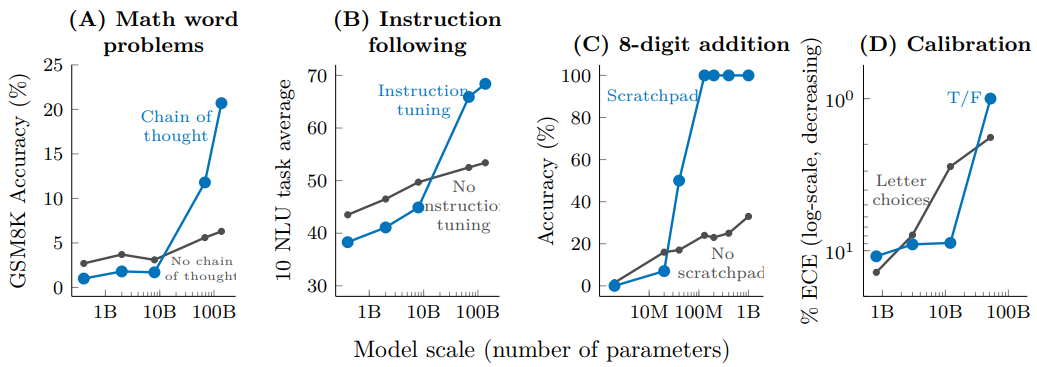

人工智能领域以数据为中心的AI,即在模型相对固定的前提下,通过提升数据的质量和数量来提升整个模型的训练效果。提升数据集质量的方法主要有:添加数据标记、清洗和转换数据、数据缩减、增加数据多样性、持续监测和维护数据等。未来数据成本在大模型开发中的成本占比或将提升,主要包括数据采集,清洗,标注等成本。

以数据为中心的 AI:模型不变,通过改进数据集质量提升模型效果

AI大模型需要什么样的数据集

1)高质量:高质量数据集能够提高模型精度与可解释性,并且减少收敛到最优解的时间,即减少训练时长。

2)大规模:OpenAI 在《Scaling Laws for Neural Language Models》中提出 LLM 模型所遵循的“伸缩法则”(scaling law),即独立增加训练数据量、模型参数规模或者延长模型训练时间,预训练模型的效果会越来越好。

3)丰富性:数据丰富性能够提高模型泛化能力,过于单一的数据会非常容易让模型过于拟合训练数据。

数据集如何产生

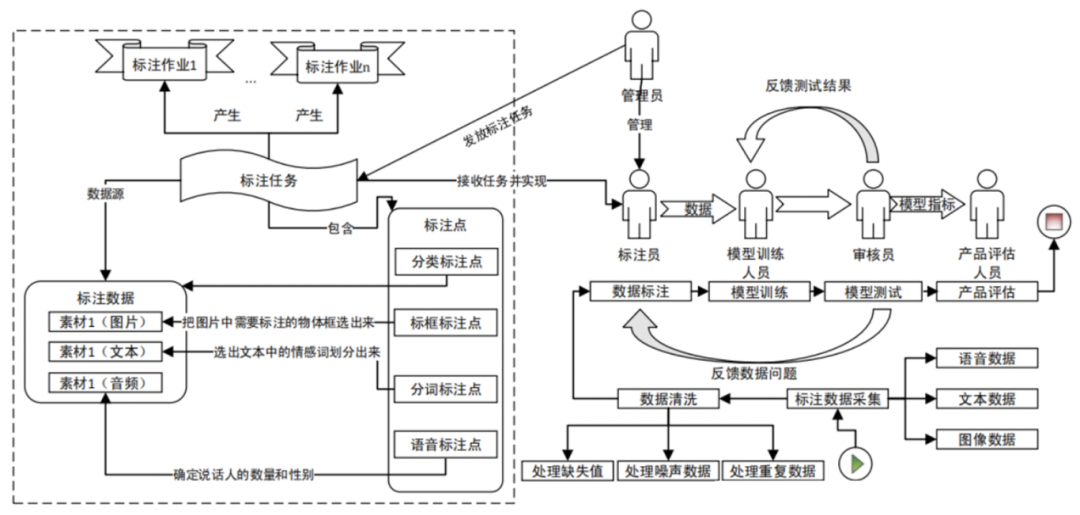

建立数据集的流程主要分为: 1)数据采集;2)数据清洗:由于采集到的数据可能存在缺失值、噪声数据、重复数据等质量问题;3)数据标注:最重要的一个环节;4)模型训练:模型训练人员会利用标注好的数据训练出需要的算法模型;5)模型测试:审核员进行模型测试并将测试结果反馈给模型训练人员,而模型训练人员通过不断地调整参数,以便获得性能更好的算法模型;6)产品评估:产品评估人员使用并进行上线前的最后评估。

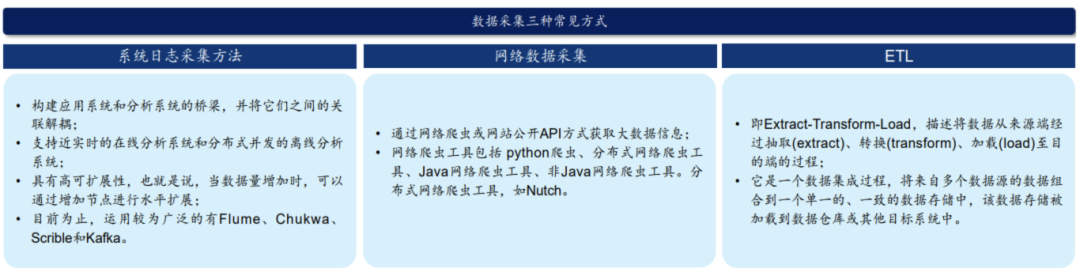

数据采集:采集的对象包括视频、图片、音频和文本等多种类型和多种格式的数据。数据采集目前常用的有三种方式,分别为:1)系统日志采集方法;2)网络数据采集方法;3)ETL。

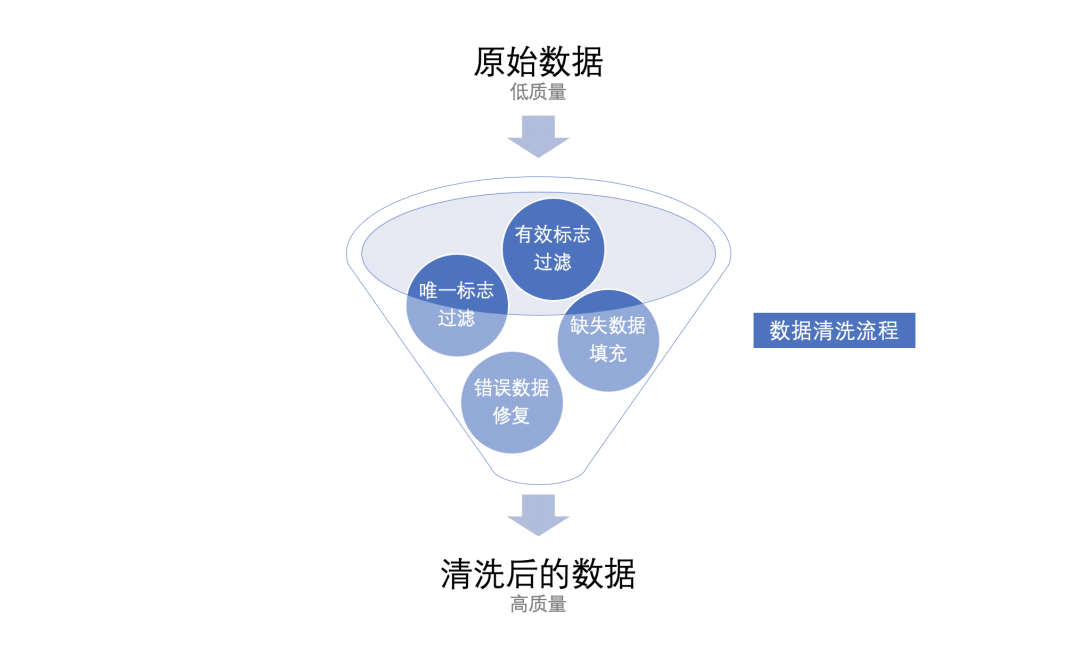

数据清洗:数据清洗是提高数据质量的有效方法。由于采集到的数据可能存在缺失值、噪声数据、重复数据等质量问题,故需要执行数据清洗任务,数据清洗作为数据预处理中至关重要的环节,清洗后数据的质量很大程度上决定了 AI 算法的有效性。

数据标注:数据标注是流程中最重要的一个环节。管理员会根据不同的标注需求,将待标注的数据划分为不同的标注任务。每一个标注任务都有不同的规范和标注点要求,一个标注任务将会分配给多个标注员完成。

模型训练与测试:最终通过产品评估环节的数据才算是真正过关。产品评估人员需要反复验证模型的标注效果,并对模型是否满足上线目标进行评估。

来源(公众号):数据治理体系

- 分享:

热门文章

- 1 AI+大数据 4个关键点:让数据治理变得简单、高效

- 2 AI+大数据 AI与数据的双向奔“赋”

- 3 荣誉奖项 【喜报】龙石数据成功入选苏州市数据创新应用实验室

- 4 数据中台 龙石数据中台V3.5.2升级 | 新增码表转换功能

- 5 荣誉奖项 龙石数据总经理练海荣获评CCSA TC601 2024年度突出贡献专家

- 6 荣誉奖项 智库生态丨龙石数据练海荣、孙晓宁受聘中国信通院政务大数据方向智库专家

- 7 公司动态 龙石数据在DAMA数据管理峰会再次分享数据要素价值运营和第三方数据质量管理

- 8 公司动态 江阴市数据局莅临龙石数据调研

- 9 公司动态 【技能提升】SQL进阶脚本,专业技能再提升,服务再升级

- 10 数据集成 龙石数据集成平台有哪些要点?