数据治理到底治什么?有没有前景

2023-03-09 18:34 浏览量:664

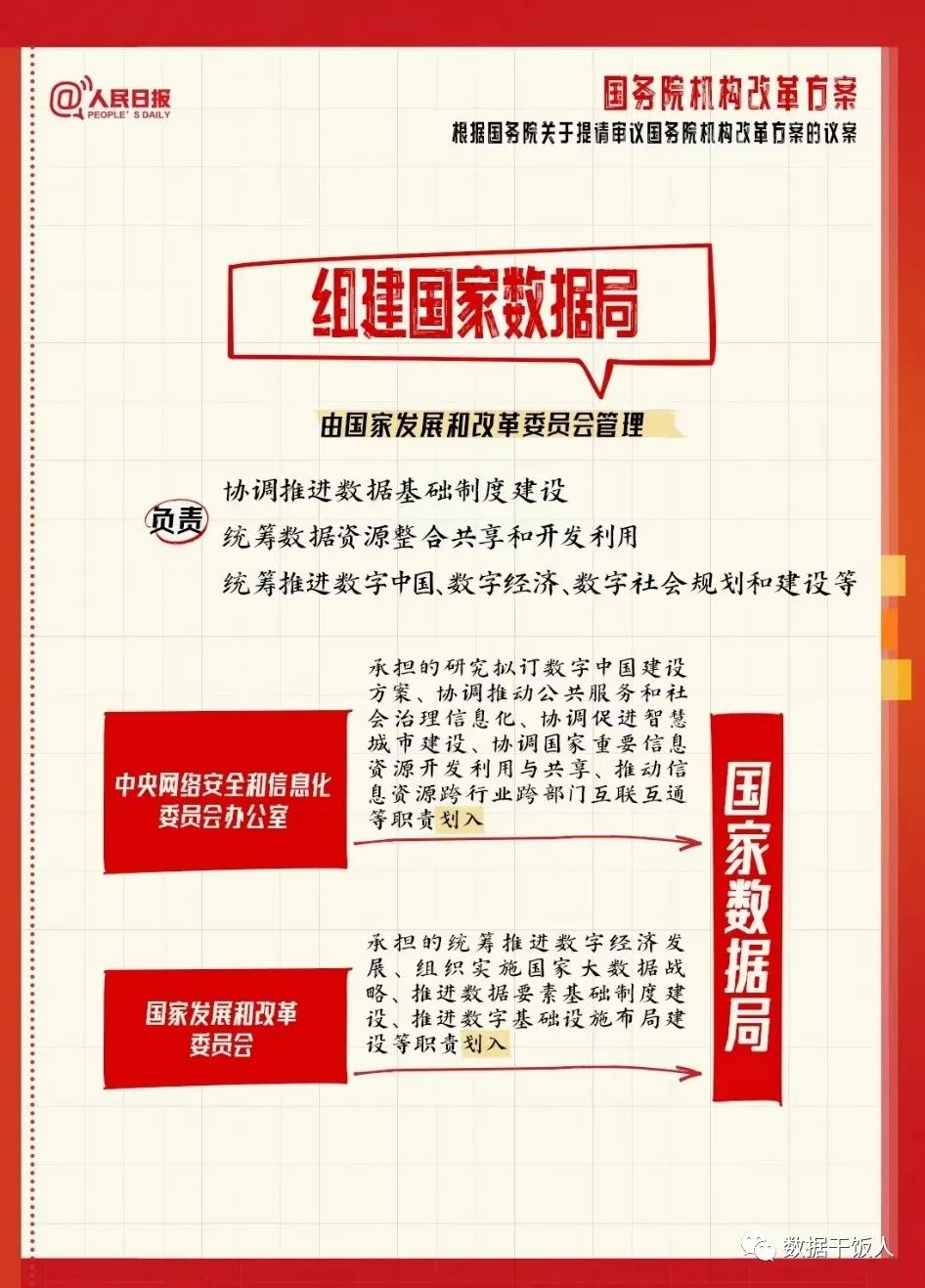

数字中国建设规划之后,两会又确定了国务院机构改革的方案,组建国家数据局,朋友圈纷纷被数据人刷屏,这可能算的上是数据人的一个高光时刻了。近期也有粉丝咨询数据治理工作的岗位前景,有没有必要考数据治理的DAMA证书,今天就花点时间聊聊数据治理那些事。

数据治理到底指的是什么?

大禹治水,是因为洪水泛滥,祸及民生题,修堤建坝河流改道,并且也要防患于未然。百度百科把数据治理定义为组织中涉及数据使用的一整套的管理行为。所以了解数据使用过程涉及的工作,也就能够更加准确地理解数据治理到底指的是什么了。

、

数字中国建设,首先要解决有数据的问题,也就是数据基建,连数据都没有或者没采集,上层建筑也就没有根基,都是空谈。其次是,数据准不准,也就是质量的问题,数据脏乱差,错误数据带来错误的决策指导,还不如没有数据拍脑袋。第三阶段就是效率了,想分析个数据要等个十天半个月,决策时效也过了。最后是成本,寒冬还没过,企业数字化转型本质是追求依赖数据进行降本增效,而如果数据团队的人和资产本身成了成本大头,肯定不是长久之计。

所以,一切围绕这四大目标而进行的相关开发工作或者数据产品工具的建设,都是数据治理的范畴,比如为了获取数据,需要制定数据采集的流程和规范,对于线上业务主要是埋点采集,线下靠传感器或其他数据导入。

数据治理的工作范围和主要职责

既然数据治理的目的是为了完成数字化应用的四大目标,那么,数据治理日常的工作范畴和全貌主要包含哪些呢?

1.有数据

在数字化转型意识觉醒之前,很多企业数据是缺失不全的,甚至很多人都不知道想要分析用户行为数据,必须要先埋点采集。在一些公司中,数据分析、数据产品承担了制定埋点规范的职责,定义数据采集的规范和标注,一个功能上线,需要采集哪些字段,字段的结果和规范是怎样的等。或者散落在不同的业务系统,数据是孤岛般存在的,数据中台的概念兴起后,首要的任务就是要打破烟囱和孤岛,把数据统一汇聚起来。不同系统怎么整合和汇聚,不同部门数据打架时,该听谁的也同样需要制定数据汇聚的标注和规范。

2.数据准

主要是指数据质量问题,数据从采集、加工处理到应用要经历非常长的链路和流程,任何环节出了问题,都可能导致数据错误,所以需要建立数据质量检查和监控的标准,防患于未然,提前发现数据问题并修复

一致性:一致性是指数据是否遵循了统一的规范,数据集合是否保持了统一的格式。

完整性:完整性指的是数据信息是否存在缺失的状况,数据缺失的情况可能是整个数据记录缺失,也可能是数据中某个字段信息的记录缺失。不完整的数据所能借鉴的价值就会大大降低,也是数据质量更为基础的一项评估标准。

及时性:及时性是指数据从产生到可以查看的时间间隔,也叫数据的延时时长。及时性对于数据分析本身要求并不高,但如果数据分析周期加上数据建立的时间过长,就可能导致分析得出的结论失去了借鉴意义。

准确性:准确性是指数据记录的信息是否存在异常或错误。和一致性不一样,存在准确性问题的数据不仅仅只是规则上的不一致。更为常见的数据准确性错误就如乱码。其次,异常的大或者小的数据也是不符合条件的数据。

有效性:对于数据的值、格式要求符合数据定义或业务定义的要求,如某些电话、邮箱的格式。

唯一性:针对某个数据项或某组数据,没有重复的数据值。值必须是唯一的如ID类数据。

3.效率高

主要包括数据生产者和数据使用者两个方面,即既要高效生产,又可以快速输出业务价值。这就主要涉及数据仓库的资产化管理和建设,比如元数据管理、主数据管理等。

数据生产者:模型开发效率高,可复用,通过数据仓库分层建设,提升开发效率和运维效率。源端业务数据变动只需要修改一层底表逻辑,而不需要所有任务全部改一遍。

数据消费者:数据找得到,敢使用。可以清楚的知道自己需要的数据指标存放在哪个指标中,统计逻辑是什么,放心大胆的使用。

这就要求数据资产管理的数据产品,既能满足数仓建设的高效率,同时也要具备资产索引地图的能力,方便业务查找和使用数据。

4.成本低

大数据数据量大、价值密度低导致需要大量的服务器来存储每天海量增长的数据,虽然说Hadoop分布式的能力支持廉价服务器的部署,但每台4w也架不住几千几万台。所以,数据不可能只增不减,还需要持续做加法,通过数据的冷热分离、无效数据归档删除,高耗时任务的治理来降低数据的存储和计算成本。

数据治理涉及的工具及数据产品体系

1.数据埋点管理系统

将埋点规范集成到数据管理后台中,让整个埋点流程线上化流转,提升埋点工作的规范化程度,减少漏埋和错埋。即使像一些用户行为分析系统力推的无埋点或可视化埋点,也都有埋点数据管理模块提供界面化的指标定义能力。早期的埋点规则主要靠excel世代相传

2.数据仓库开发与管理

汇聚入湖的数据需要加工处理才能发挥其价值,尤其对于湖仓一体的架构中,涉及到结构化数据的数据仓库模块的开发。按照业务需求的逻辑对数据进行ETL处理,输出一个个的数据模型。可以将数据模型开发规范和流程融入到系统当中,是一种低代码的思想减少数仓建模的开发代码开发,提升模型的规范化和复用性,比如阿里的Datapin,系统化的好处在于方便前置化管理建模过程,而不是先污染后治理,弊端是可能没有开发自己写代码那么灵活。

数据质量监控

数据不准可以说是业务和数据团队最头疼的问题之一,业务拿到数据不敢用,先来问下开发准不准,开发不自信,看了任务看了代码说应该没问题。数据质量监控围绕一致性、及时性、完整性、准确性维度构建丰富灵活的数据质量规则配置和自动化预警能力,让数据开发人员更自信,只要监控没报警,就可以拍着胸脯说,是不是业务上有什么变化。

数据资产管理地图

酒香也怕巷子深,数据模型开发完了,找得到、敢使用才能提升复用性,数据地图通过资产目录共享和强大的数据检索能力,提供逛数据、找数据的能力,同时需要具备丰富的模型元数据信息,让数据消费者快速判断是不是自己所需要的数据,如何使用。

数据成本治理与优化

虽然说大家默认数据部门是成本中心,但是在这个寒冬之下,也要勒紧裤腰带,虽不能开源但总要节流,哪些数据长期无人使用可以归档或删除,哪些任务SQL性能奇差一个任务执行10多个小时,消耗大量CPU、GPU?数据成本优化核心目标是建立数据健康分评价体系,自动化检测治理目标,并提供归档、删除等自动化治理动作,从而释放服务器资源,常态化做减法。

数据血缘

主要解决数据的追根溯源的问题,例如数据异常,需要通知下游业务,数据治理时需要下线或者删除,下游有没有人在使用,没有血缘就不敢治理,数据&服务只增不减

统一数据权限

数据安全问题事关企业生死存亡和数据团队的“钱途”,统一权限主要是建立数据资产权限申请、授权、审计对应的流程,从而保证数据既共享又安全。

数据治理的岗位有没有前途

数据治理可以说是数字化建设最基础的根基部分,在数字化建设初期需求量非常大,即使有些企业追求短期的数据应用价值快速可见,终究还是要回过头来还数据治理的技术债,所以如果当前从事的是数据治理方向的开发或者产品工作,就先花1-2年把这个方向的基础打扎实,然后再向雨后春笋一样,遇到合适的机会快速向上。如果开始选择职业方向,那就根据自己专业背景决定是否以这个方向切入,计算机、统计、算法、数学等专业背景的上手数据治理相关工作相对会更快。

来源:数据干饭人

作者:千冰仪

- 分享:

热门文章

- 1 AI+大数据 4个关键点:让数据治理变得简单、高效

- 2 AI+大数据 AI与数据的双向奔“赋”

- 3 荣誉奖项 【喜报】龙石数据成功入选苏州市数据创新应用实验室

- 4 数据中台 龙石数据中台V3.5.2升级 | 新增码表转换功能

- 5 荣誉奖项 龙石数据总经理练海荣获评CCSA TC601 2024年度突出贡献专家

- 6 荣誉奖项 智库生态丨龙石数据练海荣、孙晓宁受聘中国信通院政务大数据方向智库专家

- 7 公司动态 龙石数据在DAMA数据管理峰会再次分享数据要素价值运营和第三方数据质量管理

- 8 公司动态 江阴市数据局莅临龙石数据调研

- 9 公司动态 【技能提升】SQL进阶脚本,专业技能再提升,服务再升级

- 10 数据集成 龙石数据集成平台有哪些要点?